Sztuczna inteligencja Google'a uczy się analizować świat za pomocą aparatu w smartfonie

Arkadiy Andrienko

Arkadiy Andrienko

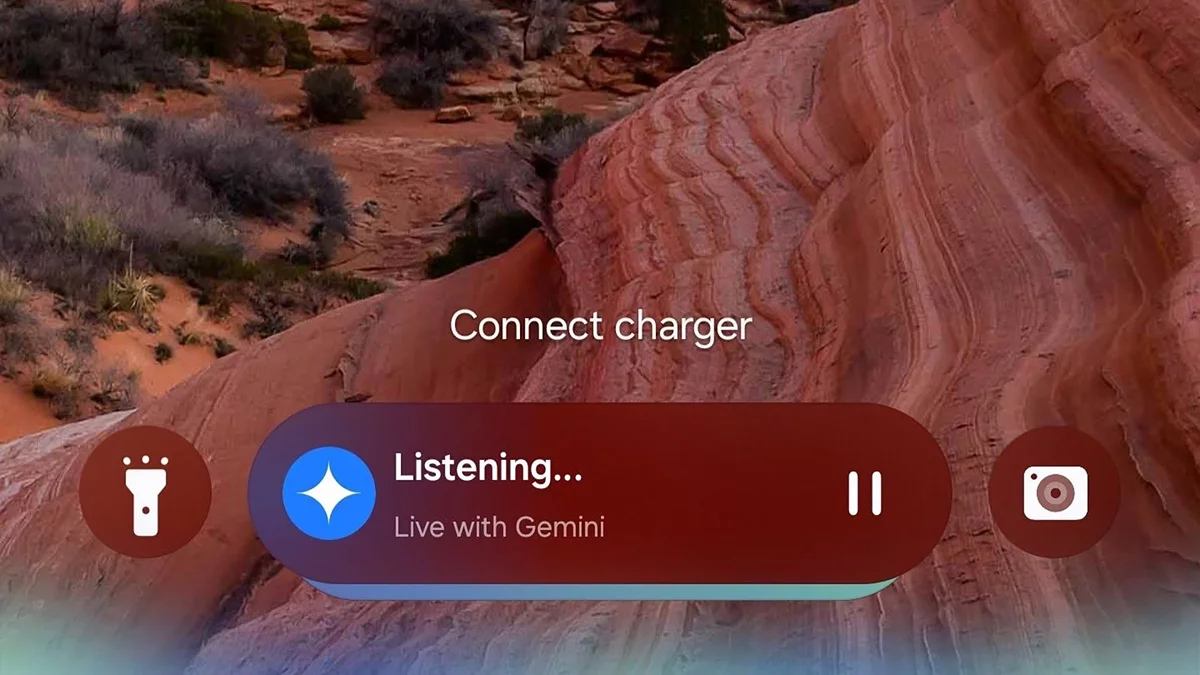

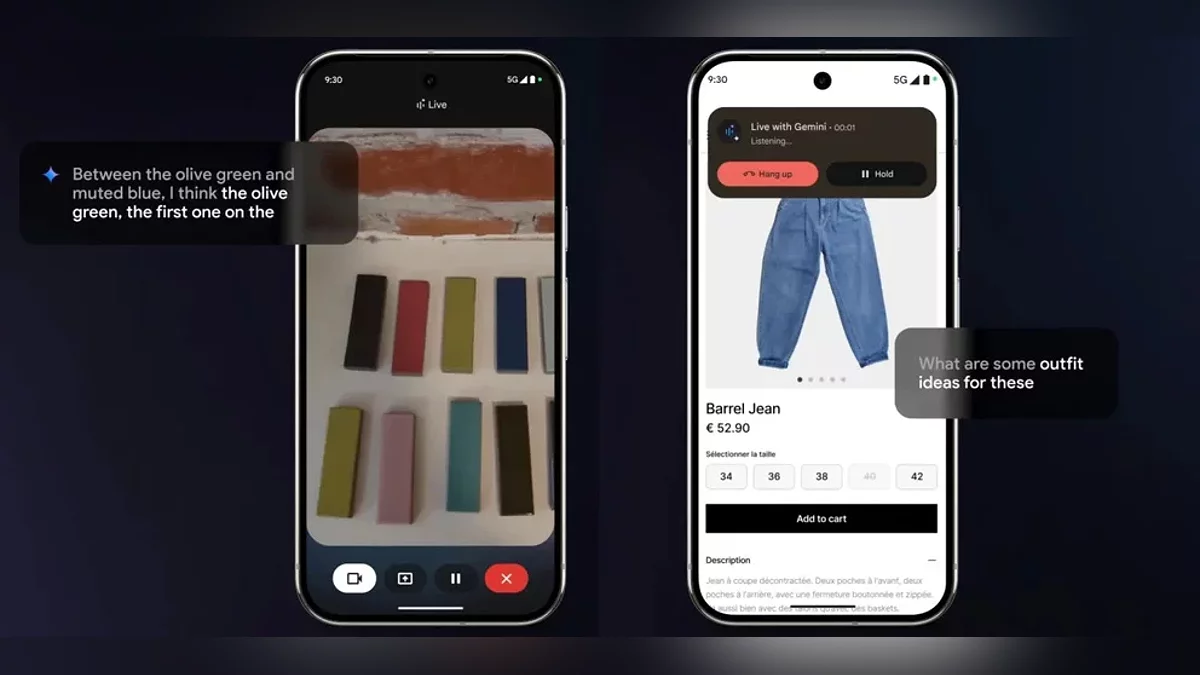

W MWC w Barcelonie Google zaprezentowało przełomowe nowe funkcje dla swojego asystenta AI, Gemini. Począwszy od marca, subskrybenci planu Google One AI Premium będą mogli przekształcić swoje smartfony w „oczy” zasilane AI dzięki dwóm kluczowym innowacjom—Analizie Wideo na Żywo i Inteligentnemu Udostępnianiu Ekranu.

Analiza Wideo na Żywo umożliwia asystentowi natychmiastowe przetwarzanie wejścia z kamery w czasie rzeczywistym. Użytkownicy mogą skierować kamerę na kawałek odzieży, aby uzyskać porady dotyczące stylizacji lub zeskanować pokój, aby otrzymać sugestie dotyczące wystroju wnętrz. Gemini nie tylko „widzi” to, co jest na ekranie—aktywnie angażuje się w dialog. Na przykład, użytkownicy mogą poprosić go o optymalizację trasy nawigacyjnej lub wyjaśnienie skomplikowanego wykresu w prezentacji, otrzymując wyjaśnienia w dynamicznym, konwersacyjnym formacie.

Na razie te funkcje są dostępne tylko na urządzeniach z systemem Android z wielojęzycznym wsparciem. Na stoisku Google firma zaprezentowała Gemini działające na urządzeniach Samsung, Xiaomi i innych partnerów, podkreślając kompatybilność między markami. Nie ma jeszcze informacji, kiedy użytkownicy iOS uzyskają dostęp.

Ogłoszone aktualizacje to tylko jeden krok w kierunku ambitnego projektu Astra firmy Google. Do 2025 roku firma planuje opracować uniwersalnego asystenta multimodalnego zdolnego do:

- Analizowania danych wideo, audio i tekstowych jednocześnie;

- Utrzymywania kontekstu rozmowy przez maksymalnie 10 minut;

- Integracji danych z Wyszukiwania, Lens i Map w celu uzyskania kompleksowych rozwiązań.

Chociaż Google nie ogłosiło oficjalnie Astra jako samodzielnego produktu, eksperci spekulują, że jego funkcje będą stopniowo integrowane z Gemini, intensyfikując konkurencję z ChatGPT. Warto zauważyć, że OpenAI oferuje rozszerzony tryb głosowy z analizą ekranu od grudnia 2023 roku, ale Google stawia na głęboką integrację z własnym ekosystemem.

Możliwość przetwarzania informacji wizualnych w czasie rzeczywistym przez AI zaciera granice między światem cyfrowym a fizycznym. Użytkownicy nie tylko wchodzą w interakcję z „mówiącym asystentem”, ale angażują się z aktywnym uczestnikiem swoich codziennych zadań—od zakupów po naukę. Z uruchomieniem Gemini Vision, asystenci AI wkraczają w erę hiper-kontekstowej interakcji, gdzie kluczowe pytanie zmienia się z „Jak zapytać?” na „Co pokazać?”

Jedno ważne pytanie pozostaje: prywatność. Jak Google ochroni dane przesyłane przez kamerę i ekran? Firma zapewnia, że wszystkie analizy są prowadzone zgodnie z rygorystycznymi standardami bezpieczeństwa, ale pełne szczegóły zostaną ujawnione dopiero po oficjalnym wydaniu funkcji.